Веб-скрапинг от А до Я: принципы работы, разновидности и сценарии применения

Сбор больших объемов данных с веб-сайтов вручную — задача неблагодарная. Она может отнять часы, недели, а в некоторых случаях и месяцы. Всё зависит от масштаба. Чтобы ускорить этот процесс в разы, самым эффективным решением становится веб-скрапинг.

Сегодня существует множество инструментов, способных бесшовно собирать колоссальные массивы информации с любых ресурсов. В этой статье мы разберем всё, что нужно знать о веб-скрапинге. Как именно он работает? Какие типы инструментов существуют? Почему вам стоит задуматься о его внедрении? Не будем терять ни минуты. Приступим.

Основные тезисы

- Веб-скрапинг — это автоматизированный метод быстрого и эффективного извлечения больших объемов данных с сайтов в промышленных масштабах.

- Собранная информация используется для обучения моделей машинного обучения, мониторинга цен, анализа конкурентов, маркетинговых исследований и отслеживания трендов.

- Инструменты классифицируются по типу разработки, платформе и среде выполнения.

- Легальность: скрапинг законен, если собираются общедоступные данные и не нарушаются условия использования (Terms of Service) целевого ресурса.

- Преимущества: высокая скорость, снижение затрат, улучшение качества принятия решений, масштабируемость и гибкость.

- Альтернативы: использование API, открытых датасетов и партнерских соглашений по обмену данными.

Понимание веб-скрапинга

Что такое веб-скрапинг? Это процесс автоматического извлечения информации с сайта или любой другой онлайн-платформы с помощью специализированного софта — веб-скраперов. Такая автоматизация позволяет бизнесу и аналитикам получать огромные массивы данных без необходимости копировать что-либо вручную.

Инструмент заходит на целевой сайт. Читает HTML-код. Находит нужные сведения. А затем сохраняет их в чистом, удобном формате: CSV, JSON или сразу в базу данных. Информация, полученная таким путем, проходит очистку и отправляется в работу. Спектр задач широк: от тренировки ИИ и мониторинга прайсов до глубокого анализа конкурентов, новостной повестки и рыночных тенденций.

Как работают веб-скраперы

Механика работы скраперов прозрачна. Бот отправляет запрос к целевой веб-странице, получает её HTML-код и вытягивает конкретные данные, заданные в настройках вашего проекта. Инструмент забирает только то, что нужно. Никакого цифрового мусора. Это экономит бюджет и время, отсекая бесполезную информацию.

Собранные результаты сохраняются в форматах вроде CSV или JSON, полностью готовых к дальнейшей обработке. Давайте рассмотрим этот автоматизированный процесс детальнее.

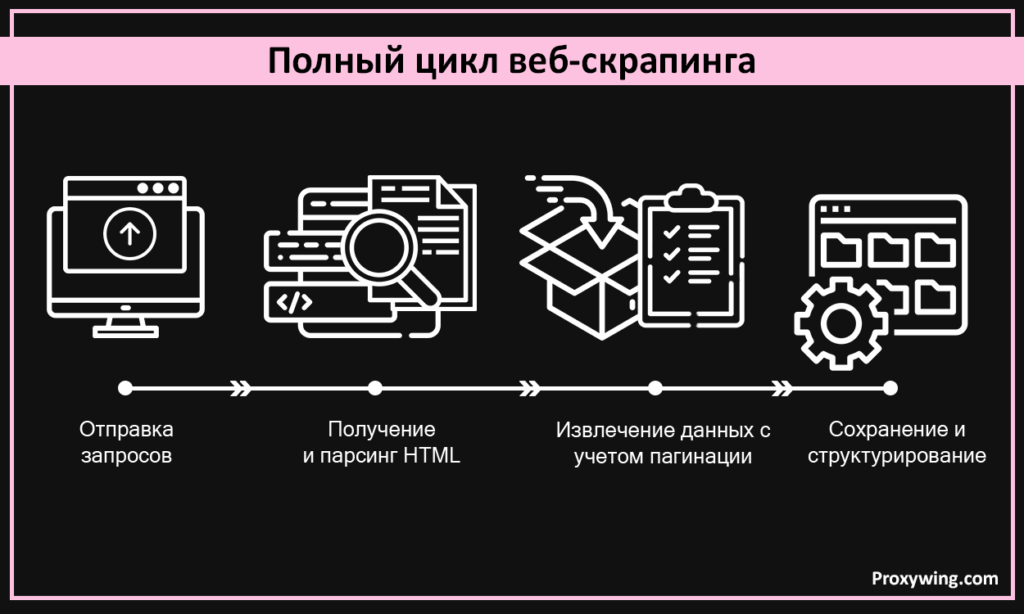

Полный цикл веб-скрапинга

- Отправка запросов: программа посылает HTTP-запрос к странице, имитируя поведение обычного браузера.

- Получение и парсинг HTML: скрапер загружает код страницы и сканирует теги, чтобы найти нужную информацию согласно конфигурации.

- Работа с пагинацией: веб-краулеры переходят по ссылкам «следующая страница» или номерам страниц, чтобы охватить весь доступный контент на платформе.ТСПУ

- Извлечение данных: инструмент «выдергивает» детали: текст, цены, изображения или метаданные.

- Сохранение и структурирование: финальный этап — запись данных в упорядоченном виде (таблицы, JSON, БД) для удобного анализа.

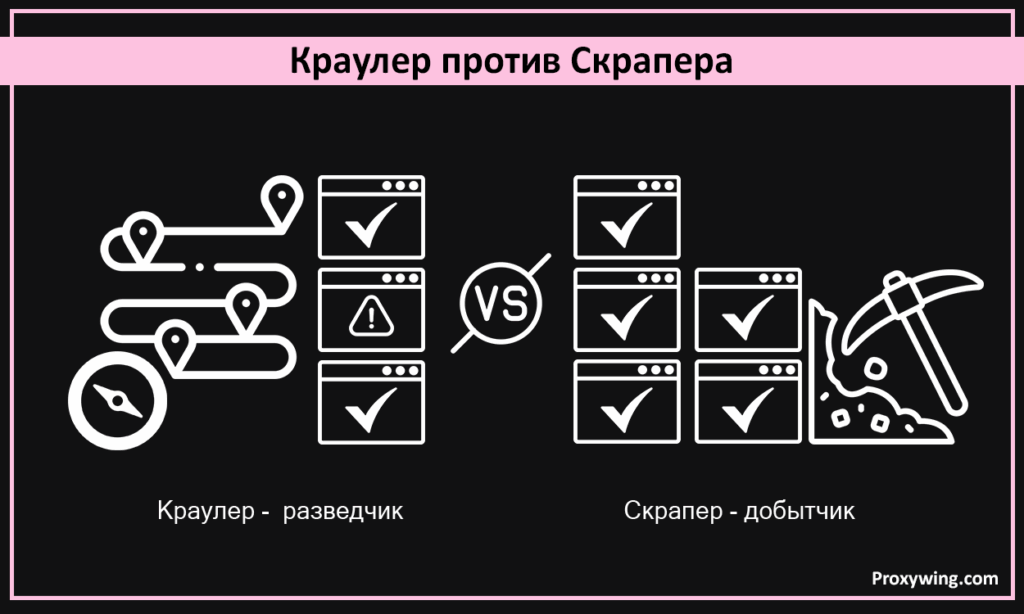

Краулер против Скрапера

Люди часто путают эти понятия, а зря. Хотя оба инструмента используются в процессе добычи данных, роли у них разные.

- Краулер (Crawler): Это разведчик. Его задача — обнаружение страниц. Он «ползает» по сайту, переходя по ссылкам, находит новые URL и составляет карту ресурса.

- Скрапер (Scraper): Это добытчик. Он извлекает данные. Скрапер читает HTML-код на каждой странице, найденной краулером, и забирает конкретную информацию. Точность выгрузки зависит исключительно от того, как вы его настроите.

Типы веб-скраперов

Современные инструменты для парсинга классифицируются в зависимости от того, как они созданы и где развернуты. Давайте рассмотрим самые популярные варианты.

По типу разработки

Здесь выбор стоит между самописными решениями и готовыми инструментами. В чем разница?

- Кастомные (самописные) инструменты: Их создают с нуля, используя языки программирования, такие как Python или JavaScript. Разработчики часто применяют библиотеки вроде BeautifulSoup для ускорения работы.

- Плюсы: Поскольку код пишется под конкретную задачу, вы получаете полный контроль. Такие решения справляются со сложными сайтами и отлично масштабируются.

- Минусы: Требуются технические навыки. Разработка стоит дороже. Поддержка кода требует времени.

- Готовые (Pre-built) инструменты: Это сервисы с интерфейсом «укажи и кликни». Они идеальны для тех, кому нужно начать работу немедленно.

- Плюсы: Просты для новичков. Экономят время. Не требуют глубоких знаний кода.

- Минусы: Меньше гибкости. Могут «буксовать» на сайтах со сложной структурой или защитой.

Выбор между кастомным и готовым решением зависит от задачи, технической экспертизы команды и срочности. Если нужно построить сложную систему под специфические нужды — пишите свой код на Python.

По типу платформы

В этой категории есть три опции: расширения для браузера, десктопный софт и API-решения.

- Браузерные расширения: Простые утилиты, живущие внутри Chrome или Safari. Хороши для мелких, разовых задач. Но их возможности автоматизации и масштабирования крайне ограничены.

- Десктопное ПО: Эти программы мощнее расширений. Они устанавливаются на компьютер и рассчитаны на более крупные проекты. Однако их производительность напрямую зависит от ресурсов вашего «железа».

- Решения на базе API: Эти инструменты пропускают этап прямого парсинга HTML, возвращая сразу чистые, структурированные данные через API.

- Преимущество: Самая высокая скорость. Они используют облачные ресурсы, которые можно настроить под любую нагрузку и бюджет. Масштабируемость здесь на порядок выше, чем у расширений или десктопного софта.

По среде выполнения

Здесь мы выделяем два типа: локальные скрипты и облачные скраперы.

- Локальные скрипты: Обычно это код (например, на Python), который запускается прямо на вашем компьютере.

- Нюансы: Легко контролировать, но скорость ограничена вашим интернет-каналом и мощностью ПК. Для крупных задач они ненадежны: выключился компьютер — процесс встал.

- Облачные инструменты: Как можно догадаться, они работают на удаленных серверах.

- Преимущества: Высокая скорость, стабильный аптайм и отличная масштабируемость. Они эффективнее справляются с ротацией IP-адресов.

- Минус: Обычно это дороже. Впрочем, модели ценообразования гибки: можно найти баланс между стоимостью и пользой под конкретные нужды.

Почему Python так популярен для веб-скрапинга?

Python — безоговорочный лидер в мире написания скриптов для сбора данных. Причина такой популярности проста — библиотеки. Их арсенал огромен, и они доступны каждому разработчику.

Вот главные инструменты в экосистеме Python:

- Requests — для отправки HTTP-запросов.

- BeautifulSoup и lxml — мастера по парсингу HTML-кода.

- Scrapy — полноценный фреймворк, объединяющий скрапинг и краулинг.

Использование библиотек вроде BeautifulSoup делает работу программиста в разы проще. Код пишется быстрее. Ошибок меньше.

Для чего используется веб-скрапинг?

У этой технологии множество применений в реальном мире. Она работает в самых разных индустриях. Вот наиболее распространенные сценарии:

Мониторинг цен

Бизнес и аналитики отслеживают стоимость товаров на десятках сайтов одновременно. Собранные данные становятся фундаментом стратегии. Это позволяет оставаться конкурентоспособным, мгновенно корректировать ценовую тактику и видеть изменения рынка в режиме реального времени.

Маркетинговые исследования

Прежде чем инвестировать, нужно знать почву. Исследование рынка — первый шаг. С помощью скрапинга компании собирают досье на конкурентов: продукты, отзывы клиентов, отраслевые тренды. Это дает понимание спроса и предложения. Без этих метрик успех невозможен.

Мониторинг новостей и контента

Организации и маркетологи аккумулируют статьи, посты и апдейты из разных источников, чтобы держать руку на пульсе или наполнять контент-агрегаторы. Данные собираются из множества каналов, а затем анализируются алгоритмами машинного обучения. Цель — выудить самые ценные инсайты.

Анализ настроений (Sentiment Analysis)

Особенно актуально для финансов. Фирмы парсят соцсети, форумы и сайты с отзывами. Им важно знать общественное мнение о бренде или продукте. Решения принимаются на основе реальных эмоций пользователей. Никаких догадок. Только факты.

Генерация лидов (Lead Generation)

Отделы продаж и агентства извлекают контакты, бизнес-профили и списки компаний из каталогов. Так формируются базы потенциальных клиентов. Затем эти данные загружаются в CRM-системы (например, Salesforce) для дальнейшей проработки.

Легален ли веб-скрапинг?

Сам по себе скрапинг не является преступлением. Однако всё зависит от методов и места действия. Вот ключевые аспекты законности, которые нужно понимать:

- Публичные данные безопасны. Информацию, доступную любому посетителю без авторизации, обычно можно собирать.

- Условия использования (ToS) имеют значение. Некоторые сайты прямо запрещают скрапинг в своих правилах. Игнорирование этого факта чревато последствиями. Юридическими исками или баном.

- Объем трафика. Если вы завалите сайт запросами, его серверы могут рухнуть. Заметит админ подозрительную активность с одного IP — заблокирует доступ мгновенно.

- Авторское право никуда не делось. Даже если данные открыты, использовать их нужно с оглядкой на копирайт.

Преимущества и ценность для бизнеса

- Быстрое извлечение данных. Автоматизация ускоряет процесс в тысячи раз. Собирать информацию вручную — непозволительная трата времени.

- Экономическая эффективность. Скрипт дешевле штата аналитиков, копирующих данные вручную.

- Взвешенные решения. Бизнес получает массив фактов для аналитических систем. Лидеры компаний опираются на цифры, а не на интуицию.

- Конкурентное преимущество. Парсинг сайтов соперников вскрывает их предложения. Вы можете оптимизировать свою стратегию и дать клиентам больше ценности.

- Масштабируемость. Нужно собрать миллион записей? Легко. Никакой дополнительной ручной работы.

- Гибкость. Инструменты настраиваются под любые нужды. Вы получаете именно тот формат данных, который необходим.

Вызовы и лучшие практики

Несмотря на плюсы, веб-скрапинг — это полоса препятствий. О трудностях нужно знать заранее.

Преодоление защиты от ботов

Многие сайты обороняются. Капчи (CAPTCHA), лимиты запросов, блокировка по IP. Чтобы обойти это, нужно действовать умно. Замедляйте скорость запросов. Используйте ротацию IP-адресов через резидентные или мобильные прокси. Это минимизирует риск бана.

Поддержание точности данных

Сайты меняют верстку. Часто. Это ломает настройки скрапера. В итоге вы получаете ошибки или битые данные.

- Валидируйте результаты.

- Следите за логами ошибок.

- Обновляйте код скрапера при первых признаках смены структуры сайта.

Этика и комплаенс

Соблюдайте правила. Не трогайте сайты, запрещающие доступ ботам. Собирайте только то, что лежит в открытом доступе. Уважайте авторские права.

Альтернативы веб-скрапингу

Если парсинг вам не подходит, есть и другие пути получения информации:

- API: Многие платформы (соцсети, маркетплейсы) предлагают официальные API. Это легальный «черный ход». Вы получаете структурированные данные напрямую, минуя возню с HTML.

- Открытые датасеты: Правительства и научные институты публикуют огромные массивы данных. Демография, финансы, транспорт, экология. Бери и пользуйся.

- Партнерства: Договоритесь с компанией, чьи данные вам нужны. Или купите их у надежных провайдеров. Да, это дороже, но вы получаете чистую информацию без технических головных болей.

Заключение

Веб-скрапинг — мощная стратегия. Она позволяет бизнесу аккумулировать знания из интернета быстро и масштабно. Эта информация питает аналитику, улучшает решения и стимулирует продажи.

Но действовать нужно ответственно. Не нарушайте закон. Учитывайте затраты. Иногда проще купить чистые данные, чем добывать их самому, рискуя блокировками.

Часто задаваемые вопросы (FAQ)

1. Могут ли сайты обнаружить скрапинг?

Да. Системы защиты отслеживают всплески трафика, отсутствие заголовков браузера или массовые запросы с одного IP. Использование прокси необходимо, чтобы снизить заметность.

2. Как парсить сайты бесплатно?

Существует множество опенсорсных инструментов. BeautifulSoup, Requests, расширения для браузеров. Благодаря развитию ИИ эти инструменты становятся умнее с каждым годом.

3. Какой способ самый безопасный и легальный?

Собирайте только публичные данные. Читайте условия использования (ToS). Соблюдайте законы об авторском праве.

4. Какие языки, кроме Python, подходят для скрапинга?

Выбор велик. JavaScript (Node.js), Ruby, PHP, Go и Java. У всех есть мощные библиотеки для написания парсеров.

5. В чем разница между веб-скрапингом и майнингом данных (Data Mining)?

Скрапинг — это сбор сырых данных с сайтов. Майнинг — это анализ больших массивов информации для поиска скрытых закономерностей и инсайтов. Одно добывает руду, другое ищет в ней золото.