Руководство по парсингу eBay: создаем мощные скраперы с Puppeteer, Playwright и Python

В 2025 году eBay остается одной из самых популярных платформ электронной коммерции. Аудитория площадки превышает 130 миллионов активных покупателей ежемесячно. Колоссальная цифра. Такая популярность делает eBay идеальным источником данных для бизнеса и исследователей. Отсюда можно извлекать массу полезной информации. Эти данные помогают принимать взвешенные, стратегически важные решения.

Парсинг (или веб-скрапинг) eBay — это, прежде всего, сбор информации. Речь идет о товарных листингах, ценах, вариациях продуктов и многом другом.

Использование скрапера значительно упрощает задачу. Это намного быстрее и эффективнее, чем копировать данные вручную. В этом подробном руководстве мы обсудим веб-парсинг детально. Вы узнаете, как создавать мощные инструменты для сбора данных с eBay, используя Puppeteer, Playwright и другие инструменты на базе Python. Начнем с краткого обзора ключевых моментов этого гайда.

Главные выводы

- Веб-скрапинг позволяет бизнесу собирать общедоступные данные: объявления, цены, варианты товаров, информацию о продавцах и сигналы продаж.

- Выбор инструмента для масштабирования зависит от сложности целевой страницы, объема задач и специфических требований. Puppeteer, Playwright и инструменты на Python — три самых популярных варианта.

- Понимание структуры страниц eBay критически важно. Без этого надежный парсинг невозможен.

- Масштабирование сбора данных в e-commerce требует стратегий обхода блокировок. Сюда входят интеграция прокси, создание задержек между запросами и использование правильных заголовков.

- Используйте BrowserQL для высоконагруженного сбора данных корпоративного уровня.

Что такое веб-парсинг eBay?

Это процесс автоматического сбора общедоступной информации с сайта eBay. Процесс выполняется специальными скриптами или программным обеспечением. Ручной сбор здесь не нужен. Использование скраперов позволяет быстро аккумулировать огромные массивы данных. Затем эту информацию можно загружать в аналитические инструменты. Это помогает направлять бизнес-решения в нужное русло.

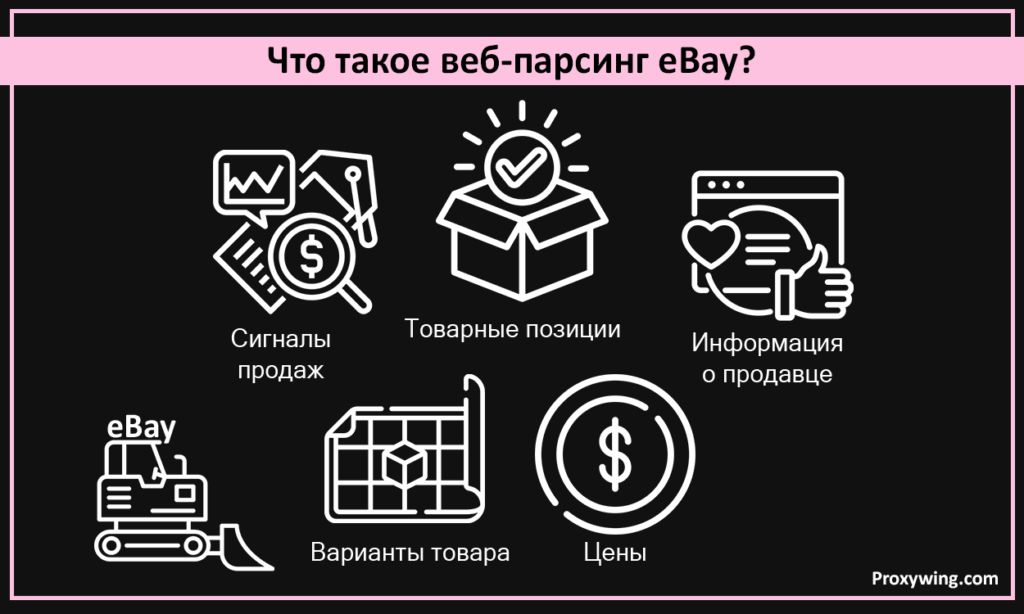

В зависимости от вашей цели, парсинг обычно включает сбор широкого спектра данных. Вот какая информация чаще всего извлекается со страниц товаров, результатов поиска и профилей продавцов:

- Товарные позиции: Сюда входят заголовки, описания, категории и изображения.

- Цены: Текущая стоимость товара, скидки, ставки на аукционах и цена «Купить сейчас» (Buy It Now).

- Варианты товара: Размер, цвет, состояние (новое/б/у) и доступность.

- Информация о продавце: Имя продавца, рейтинг, количество отзывов и местоположение.

- Сигналы продаж: Количество доступных единиц и число уже проданных товаров.

При парсинге решение за вами. Вы сами определяете, какие данные должен собирать скрипт. Чтобы не тратить время и ресурсы впустую, всегда лучше проектировать скраперы под конкретную задачу. Собирайте только то, что вам действительно нужно.

Зачем парсить eBay?

- Мониторинг цен: Этот процесс помогает бизнесу отслеживать ценообразование конкурентов в режиме реального времени. Это позволяет корректировать собственные стратегии. Оставаться конкурентоспособным.

- Исследование конкурентов: Веб-скрапинг помогает анализировать листинги соперников, эффективность продавцов и их ценовые тактики.

- Анализ продуктов и рынка: Прежде чем выходить на новый рынок, бизнесу нужно выявить товары с высоким спросом. Найти популярные варианты. Отследить зарождающиеся тренды. Парсинг справляется с этим эффективно.

- SEO и оптимизация листингов: Компании используют собранные данные, чтобы понять, какие ключевые слова и форматы объявлений работают лучше всего. Это повышает видимость.

- Веб-автоматизация и эффективность: Скрапинг помогает автоматизировать рутинные исследовательские задачи. Он позволяет масштабировать сбор данных для отчетов и оповещений.

Понимание структуры страницы и DOM на eBay

Прежде чем приступать к процессу парсинга, важно понять устройство веб-страниц eBay. Нужно знать, на какие элементы будет нацелен ваш скрипт. Давайте кратко разберем структуру страниц и DOM (объектной модели документа) этой платформы:

- Страницы результатов поиска: Каждый товар отображается как повторяющийся блок (карточка объявления). Обычно она содержит заголовок, цену, стоимость доставки, состояние и ссылку на страницу продукта. При парсинге ваши инструменты должны находить контейнер, который «оборачивает» каждое объявление. Затем извлекать данные из дочерних элементов, таких как название или цена.

- Страницы товара: Они гораздо более стандартизированы. Их структура остается относительно неизменной уже несколько лет. Единая страница товара обычно содержит детальную информацию: заголовок, блок цены, данные о продавце, состояние вещи, описание и фото. Важно отметить: большая часть этих данных встроена в структурированные HTML-элементы или подгружается динамически через JavaScript.

- Варианты продукта: Большинство товаров имеют несколько вариаций: размер, цвет, состояние. Часто они отображаются в виде выпадающих списков или кнопок выбора. Изменение любой из этих опций может обновить цену и наличие без перезагрузки страницы. При парсинге eBay ваши сервисы должны уметь обнаруживать эти опции. Скрипт должен перебирать их, чтобы собрать все возможные комбинации.

- Динамический контент: На этом сайте электронной коммерции есть части, которые загружаются уже после основной загрузки страницы. В этом случае простой HTML-парсинг может пропустить данные. Необходимо выполнение JavaScript. Вам потребуется правильная комбинация инструментов парсинга, чтобы захватить весь важный динамический контент.

Инструменты и библиотеки для парсинга eBay

Три основных инструмента, которые можно использовать для скрапинга eBay, включают Puppeteer, Playwright и различные утилиты Python. Давайте сделаем краткий обзор каждого из них:

- Puppeteer: Это библиотека Node.js. Она управляет реальным браузером. Использование Puppeteer идеально подходит для сбора данных со страниц, которые сильно зависят от JavaScript. С этим инструментом вы можете активно взаимодействовать со страницами. Кликать по вариантам товара. Скроллить. Главный недостаток Puppeteer — он медленнее, чем базовый парсинг запросами. Зато он надежнее для сложных целевых страниц.

- Playwright: Библиотека для Python (и не только). Похожа на Puppeteer, но более современная и гибкая. Поддерживает несколько браузеров и лучше справляется с динамическим контентом. Это хороший выбор для крупных или продвинутых проектов по парсингу. Python Playwright часто становится предпочтительным выбором, когда важны стабильность и масштаб.

- Инструменты на базе Python: В Python есть такие библиотеки, как Requests и BeautifulSoup. Или Selenium для автоматизации браузера. Их тоже можно использовать для сбора данных. Эти инструменты идеальны для парсинга простых страниц или когда важна скорость. Они отлично интегрируются с большинством инструментов анализа данных и пайплайнов. Главный минус таких решений — они могут «спотыкаться» на тяжелом динамическом контенте, если не комбинировать их с браузерными инструментами.

Актуальный код скрапера для eBay (Быстрый старт)

Ниже приведен готовый к запуску пример на Puppeteer. Он извлекает базовые данные об объявлении со страницы результатов поиска. Перед запуском кода убедитесь в соблюдении требований:

- Node.js версии 18+ для эффективной работы Puppeteer.

- Установленный Puppeteer: Вы можете установить его командой npm install puppeteer.

Пример кода:

JavaScript

importpuppeteer from"puppeteer";

construn = async() => {

constbrowser = awaitpuppeteer.launch({ headless: true});

constpage = awaitbrowser.newPage();

constsearchUrl =

"https://www.ebay.com/sch/i.html?_nkw=iphone+14";

awaitpage.goto(searchUrl, { waitUntil: "networkidle2"});

constlistings = awaitpage.evaluate(() => {

returnArray.from(document.querySelectorAll(".s-item")).map(item => ({

title: item.querySelector(".s-item__title")?.innerText || null,

price: item.querySelector(".s-item__price")?.innerText || null,

link: item.querySelector(".s-item__link")?.href || null,

}));

});

console.log(listings.slice(0, 5));

awaitbrowser.close();

};

run();Скрипт выше делает три простые вещи. Открывает eBay. Ищет по ключевому слову. Извлекает данные: заголовки, цены и ссылки.

Создание парсера eBay с помощью Puppeteer

Используя Puppeteer, вы можете легко собирать данные с eBay и других сайтов, насыщенных Javascript. Как обсуждалось ранее, Puppeteer — это библиотека Node.js, управляющая реальным браузером. Это делает ее идеальной для парсинга таких ресурсов, как eBay, где контент загружается динамически и меняется при взаимодействии пользователя со страницей.

Основные преимущества парсинга eBay с Puppeteer:

- Скорость: Отрисовывает JavaScript так же, как браузер реального пользователя.

- Надежность: Инструмент может кликать по кнопкам, фильтрам и вариантам товаров, имитируя поведение человека.

- Динамический контент: Надежен для сбора динамических цен и листингов.

- Простота использования: Легко отлаживать, запустив в не-фоновом (non-headless) режиме.

После краткого обзора давайте перейдем к шести ключевым шагам для парсинга данных eBay с использованием Puppeteer. Для каждого шага мы предоставим простой скрипт, который вы можете использовать.

Шаг 1: Запуск Puppeteer и открытие eBay

Используйте скрипт ниже:

JavaScript

constbrowser = awaitpuppeteer.launch({ headless: true});

constpage = awaitbrowser.newPage();

awaitpage.goto("https://www.ebay.com", { waitUntil: "networkidle2"});Этот скрипт запускает сессию браузера, открывает новую вкладку и загружает домашнюю страницу eBay.

Шаг 2: Выполнение поискового запроса

JavaScript

awaitpage.type("#gh-ac", "iphone 14");

awaitpage.click("#gh-btn");Код выше вводит поисковый запрос в строку поиска и отправляет форму. Совсем как настоящий пользователь.

Шаг 3: Ожидание загрузки результатов

JavaScript

await page.waitForSelector(".s-item");Эта часть программы приостанавливает скрипт. Он ждет, пока листинги результатов поиска не станут видимыми. Это гарантирует, что страница готова к парсингу.

Шаг 4: Сбор данных об объявлениях

JavaScript

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll(".s-item")).map(item => ({

title: item.querySelector(".s-item__title")?.innerText,

price: item.querySelector(".s-item__price")?.innerText,

shipping: item.querySelector(".s-item__shipping")?.innerText || "N/A",

}));

});Как только результаты загружены, скрипт считывает HTML страницы. Он извлекает детали объявления: заголовок, цену и информацию о доставке, как настроено в коде.

Шаг 5: Сохранение результатов в CSV

JavaScript

importfs from"fs";

constcsv =

"title,price,shipping\n"+

data

.map(d => `"${d.title}","${d.price}","${d.shipping}"`)

.join("\n");

fs.writeFileSync("ebay_listings.csv", csv);Этот скрипт конвертирует собранные данные в формат CSV. Затем он сохраняет их в файл под названием ebay_listings.csv для дальнейшего использования.

Шаг 6: Закрытие браузера

JavaScript

await browser.close();Наконец, этот скрипт завершает сессию браузера и освобождает системные ресурсы.

Реализовав эти шесть шагов, вы получите рабочий парсер eBay. Он сможет собирать базовую информацию со страницы результатов поиска. Позже вы сможете добавить другие возможности. Например, пагинацию (переход по страницам), прокси или обработку ошибок. Это сделает ваш скрапер более надежным.

Создаем парсер eBay с помощью Playwright (Python)

Как мы уже упоминали, Playwright для Python — это современный инструмент автоматизации. Он позволяет управлять реальными браузерами, используя популярные движки: Chromium, Firefox и WebKit. Как и Puppeteer, он отлично справляется с сайтами, перегруженными JavaScript. Например, с eBay. Однако его часто считают более стабильным и гибким. Особенно если речь идет о крупных проектах парсинга.

По сравнению с Puppeteer, использование Python Playwright дает ключевые преимущества:

- Лучшая логика ожиданий и автоматические повторные попытки (auto-retry).

- Поддержка нескольких браузеров «из коробки».

- Надежность при работе с динамическими страницами. Ощущается более уверенно.

Главные плюсы парсинга eBay через Python Playwright:

- Обработка динамического контента: Отлично рендерит элементы, созданные через JavaScript.

- Возможности ожидания: Встроенные механизмы ожидания (waiting capabilities). Это снижает количество «хрупких» скриптов, которые ломаются из-за недогрузки.

- Поддержка современных браузеров: Работает в Chromium, Firefox и WebKit.

- Экосистема: Мощная поддержка со стороны сообщества Python.

С кратким обзором закончили. Погрузимся в шаги веб-парсинга с Python Playwright.

Шаг 1: Установка зависимостей и запуск

Установите необходимые компоненты командой:

Bash

pip install playwright

playwright installЭта команда инсталлирует сам Playwright и его зависимости.

Python

fromplaywright.sync_api importsync_playwright

playwright = sync_playwright().start()

browser = playwright.chromium.launch(headless=True)

page = browser.new_page()Приведенный выше фрагмент кода Python запускает реальную сессию браузера. Ей будет управлять ваш скрипт.

Шаг 2: Определение селекторов и запуск поиска

Python

search_url = "https://www.ebay.com/sch/i.html?_nkw=iphone+14"

page.goto(search_url)Этот скрипт открывает страницу результатов поиска eBay. Здесь же определяются HTML-элементы для скрапинга. Селекторы позже будут использованы для нацеливания на заголовки, цены и ссылки.

Шаг 3: Ожидание рендеринга страницы

Python

page.wait_for_selector(".s-item")Скрипт гарантирует, что все объявления полностью загружены перед началом извлечения данных. Цель проста. Нужно предотвратить потерю информации из-за медленной загрузки страницы.

Шаг 4: Извлечение деталей продукта и вариантов

Python

items = page.query_selector_all(".s-item")

data = []

foritem initems:

title = item.query_selector(".s-item__title")

price = item.query_selector(".s-item__price")

link = item.query_selector(".s-item__link")

data.append({

"title": title.inner_text() iftitle elseNone,

"price": price.inner_text() ifprice elseNone,

"link": link.get_attribute("href") iflink elseNone

})Код выше проходит циклом по всем видимым объявлениям. Он вытягивает ключевую информацию о продукте. Здесь же можно расширить логику для обработки вариантов. Например, состояния товара или размера, если это необходимо.

Шаг 5: Сохранение извлеченных данных в CSV

Python

importcsv

withopen("ebay_listings.csv", "w", newline="", encoding="utf-8") asf:

writer = csv.DictWriter(f, fieldnames=["title", "price", "link"])

writer.writeheader()

writer.writerows(data)После извлечения данных код добавляет возможность сохранить их в CSV-файл. Удобно для повторного использования.

Шаг 6: Обработка ошибок и очистка

Python Playwright умеет обрабатывать ошибки с помощью конструкции try, как показано ниже:

Python

try:

pass # scraping logic runs here

finally:

browser.close()

playwright.stop()Этот код гарантирует правильное закрытие браузера. Даже если что-то пойдет не так. Это позволяет избежать зависания процессов браузера в системе.

Шаг 7: Запуск скрипта

После написания и сохранения полного кода пришло время его выполнить.

Bash

python ebay_scraper.pyКак только скрипт выполнится и завершится, ваш CSV-файл будет содержать извлеченные объявления.

Парсинг объявлений eBay: Какие данные можно извлечь

Вот список типичных данных, которые вы можете собрать при парсинге листингов:

- Название товара: Основное имя объявления.

- Цена: Сюда могут входить цена «Купить сейчас» (Buy It Now), текущая ставка или ценовой диапазон.

- Состояние: Новое, б/у, восстановленное и т.д.

- Варианты товара: Размер, цвет, объем памяти, комплектация.

- Доступность: Метрика, показывающая наличие на складе или оставшееся количество.

- Информация о продавце: Имя, рейтинг, количество отзывов.

- Детали доставки: Стоимость, сроки, местоположение товара.

- Изображения: Главное фото и галерея.

- Сигналы продаж: Количество проданных единиц или число наблюдателей (watchers).

Масштабирование парсинга результатов поиска eBay

Скрапинг eBay (или других сайтов) в больших объемах требует инструмента, умеющего работать с пагинацией. Ему придется переходить через множество страниц результатов, чтобы собрать все релевантные данные. На этом e-commerce сайте результаты поиска часто разбиты на страницы. Каждый URL содержит параметр page или _pgn.

Ваш парсер должен выполнить конкретный поисковый запрос. Собрать все объявления на первой странице. Затем перейти на вторую, третью и так далее. Остановка происходит, когда объявления заканчиваются.

Как найти и спарсить скрытые веб-данные

Не вся информация на сайте видна в «сыром» HTML. Некоторые данные загружаются динамически. Источники таких данных:

- Контент, отрисованный через JavaScript.

- Фоновые API-запросы.

- Элементы, скрытые в DOM.

- Данные, встроенные в JSON-скрипты.

Чтобы добраться до скрытого, используйте следующие техники:

- Применяйте инструменты автоматизации браузера, запускающие JavaScript.

- Ждите появления элементов перед началом сбора данных.

- Инспектируйте сетевые запросы (network requests), чтобы найти конечные точки API.

- Парсите встроенный JSON внутри тегов <script>.

Скрапинг скрытых данных эффективнее при использовании браузерных инструментов, чем при простых HTTP-запросах.

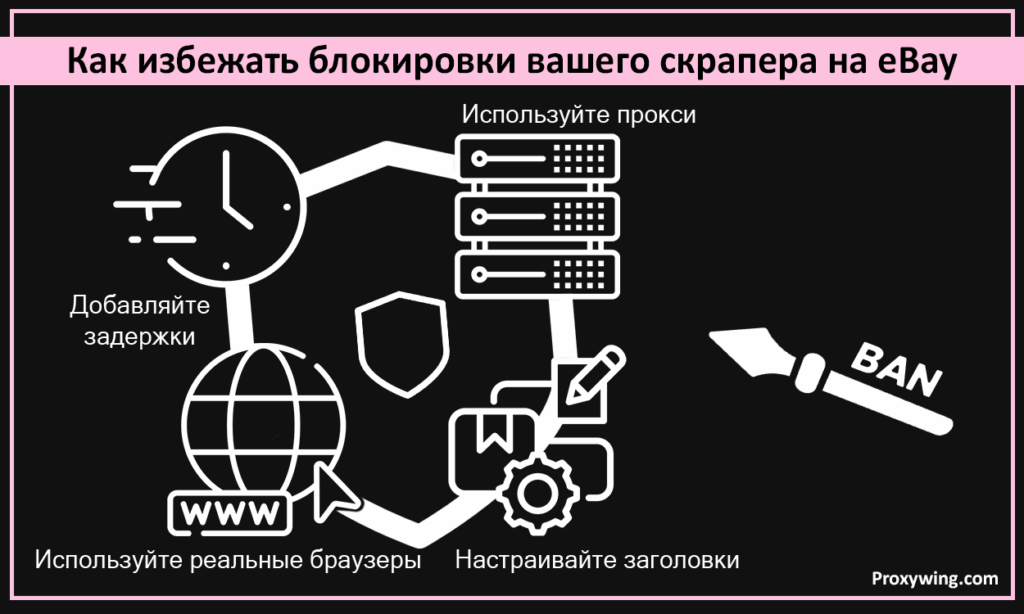

Как избежать блокировки вашего скрапера на eBay

Эта платформа активно выявляет автоматизированный трафик. И блокирует его. Чтобы предотвратить блокировку ваших GET-запросов, рассмотрите следующие техники:

- Используйте прокси: Ротируйте IP-адреса через заданные интервалы времени или количество запросов.

- Добавляйте задержки: Паузы между запросами делают трафик более похожим на человеческий.

- Настраивайте заголовки: Используйте реалистичные User-Agent, язык, часовой пояс.

- Используйте реальные браузеры: Вместо «голых» запросов.

Как вы могли заметить, цель одна — сделать ваш трафик максимально похожим на действия человека.

Масштабирование: вызовы и ограничения

Наращивая объемы парсинга eBay, вы столкнетесь с рядом проблем. Вот некоторые из них:

- Лимиты частоты (Rate limits): Слишком большое количество запросов вызывает блокировку.

- CAPTCHA: Иногда страницы требуют проверки на человечность.

- Баны по IP: Происходят, когда платформа обнаруживает повторяющиеся запросы с одного адреса.

- Проблемы конкурентности: Использование слишком большого количества браузеров замедляет системы.

- Расходы: Парсинг требует инструментов. Прокси, серверы, вычислительные ресурсы. Всё это стоит денег.

Использование BrowserQL для масштабного парсинга eBay

Использование BrowserQL — один из самых эффективных способов преодолеть вышеописанные трудности. Это облачное решение для автоматизации браузеров, созданное для крупномасштабного скрапинга. Вместо того чтобы запускать браузеры локально, вы запускаете их удаленно. В управляемой среде.

Такой подход полезен при обработке больших объемов страниц. Он позволяет управлять множеством сессий одновременно. Избегать лимитов локальных ресурсов. Это также снижает сложность инфраструктуры и повышает стабильность.

Понимание системы обнаружения ботов eBay

Чтобы обойти детекторы платформы, нужно сначала понять, как они работают.

Продвинутое обнаружение ботов

Техники, которые использует eBay, включают:

- Снятие цифровых отпечатков браузера (Fingerprinting).

- Поведенческий анализ (движение мыши, тайминги).

- JavaScript-челленджи.

- Анализ паттернов трафика.

Ограничения стелс-плагинов и прокси

Одних лишь плагинов скрытности (stealth plugins) недостаточно для обхода продвинутой защиты eBay. Кроме того, дешевые или повторно используемые прокси легко обнаруживаются и помечаются флагом.

Как обойти защиту eBay

- Качественные ротируемые прокси: Используйте продвинутые сервисы с функцией автоматической смены IP.

- Браузеры: Запускайте реальные браузеры с реалистичным поведением.

- Скорость запросов: Ограничивайте скорость и одновременность (concurrency).

- Отпечатки браузера: Ротируйте фингерпринты и сессии.

- Управляемые браузеры: Наиболее эффективны при парсинге в промышленных масштабах.

Что такое BrowserQL?

Это облачное решение для веб-скрапинга. Оно разработано для сбора данных на уровне браузера в больших объемах. Вместо запуска браузеров на вашей локальной машине, BrowserQL запускает реальные браузеры за вас в облаке. И возвращает результаты. Использование BrowserQL упрощает работу с большими объемами. Делает её надежнее. Особенно на таких сайтах, как eBay, использующих мощные антибот-системы.

Как работает BrowserQL

BrowserQL запускает реальные браузеры в облаке. Вся логика парсинга выполняется удаленно. Он также берет на себя работу с отпечатками, сессиями и масштабированием. После сбора данных он возвращает сырой HTML или извлеченную информацию через API. Для старта нужно отправить запрос в стиле GraphQL. BrowserQL выполнит работу браузера «под капотом».

Настройка BrowserQL для парсинга eBay

Выполните четыре простых шага для настройки:

- Создайте аккаунт в Bright Data.

- Получите ваш токен API BrowserQL.

- Решите, какие данные извлекать. Листинги, цены, продавцы и т.д.

- Напишите запрос (query) или мутацию (mutation) BrowserQL для загрузки страниц.

Создание REST API скрапера eBay с использованием BrowserQL (BQL)

BrowserQL позволяет создать API в стиле REST. Он может автоматически парсить eBay при каждом вызове. Такой API скрапер полезен для дашбордов, внутренних инструментов или процессов автоматизации. Пройдемся по шагам создания.

Шаг 1: Настройка окружения

Первый шаг — подготовка локального проекта для отправки запросов к BrowserQL. Это включает:

- Выбор языка бэкенда (Python или Node.js).

- Безопасное хранение токена API BrowserQL.

- Установку HTTP-клиента, например Requests, axios или fetch.

Шаг 2: Конфигурация скрипта

Ваш скрипт должен определять целевой URL eBay и заголовки для парсинга. Вам нужно настроить поисковый запрос или URL продукта, регион и формат вывода. Форматом может быть HTML или структурированные данные (CSV).

Шаг 3: Написание мутации BrowserQL

Вот пример:

GraphQL

mutation {

browserql(

url: "https://www.ebay.com/sch/i.html?_nkw=iphone+14",

render: true

) {

html

}

}Приведенный выше скрипт говорит BrowserQL, какую страницу открыть, и просит вернуть отрисованный HTML.

Шаг 4: Отправка запроса

Следующий шаг — отправка мутации на конечную точку API BrowserQL. Ниже простой скрипт для отправки запроса:

Python

importrequests

API_URL = "https://api.brightdata.com/browserql"

API_TOKEN = "YOUR_BROWSERQL_API_TOKEN"

mutation = """

mutation {

browserql(

url: "https://www.ebay.com/sch/i.html?_nkw=iphone+14",

render: true

) {

html

}

}

"""

headers = {

"Authorization": f"Bearer {API_TOKEN}",

"Content-Type": "application/json"

}

response = requests.post(

API_URL,

headers=headers,

json={"query": mutation}

)

data = response.json()

html = data["data"]["browserql"]["html"]Этот скрипт отправляет запрос к API с вашей мутацией и получает полностью отрисованный HTML.

Шаг 5: Парсинг полученного HTML

Для извлечения данных из HTML, возвращенного BrowserQL, используется библиотека Python BeautifulSoup.

Python

frombs4 importBeautifulSoup

soup = BeautifulSoup(html, "html.parser")

listings = []

foritem insoup.select(".s-item"):

title = item.select_one(".s-item__title")

price = item.select_one(".s-item__price")

link = item.select_one(".s-item__link")

seller = item.select_one(".s-item__seller-info-text")

shipping = item.select_one(".s-item__shipping")

listings.append({

"title": title.get_text(strip=True) iftitle elseNone,

"price": price.get_text(strip=True) ifprice elseNone,

"link": link["href"] iflink elseNone,

"seller": seller.get_text(strip=True) ifseller elseNone,

"shipping": shipping.get_text(strip=True) ifshipping elseNone,

})Программа выше извлекает данные объявлений из полученного HTML.

Шаг 6: Сохранение данных в CSV

Python

importcsv

withopen("ebay_listings.csv", "w", newline="", encoding="utf-8") asfile:

writer = csv.DictWriter(

file,

fieldnames=["title", "price", "link", "seller", "shipping"]

)

writer.writeheader()

writer.writerows(listings)Скрипт сохраняет извлеченные данные в файл ebay_listings.csv.

FAQ: Ответы на вопросы о парсинге eBay

Законно ли парсить eBay.com?

Это законно, пока вы собираете общедоступные данные. Не забывайте изучать “Условия использования платформы”. Избегайте сбора частных, пользовательских или персональных данных. Чтобы не получить блокировку, не перегружайте их серверы и не обходите средства защиты.

Как сканировать (кроулить) eBay эффективно?

Для эффективного сканирования сфокусируйтесь на скорости, стабильности и безопасности. Используйте пагинацию. Повторно используйте сессии браузера, чтобы избежать лишних запросов. Также рассмотрите добавление задержек. Это сделает ваш трафик более естественным.

Предоставляет ли eBay официальный API?

Да, у них есть официальный API. Разработчики могут использовать его для доступа к объявлениям, заказам и данным продавцов. Использование требует регистрации разработчика и API-ключей. У него также есть лимиты и ограничения.